Blog

LLMs für Fortgeschrittene: Tokens, Kontextfenster und Einbettungen

Große Sprachmodelle, auch bekannt als Large Language Models (LLMs), spielen eine zentrale Rolle in modernen KI-Anwendungen. Diese Modelle sind darauf trainiert, natürliche Sprache zu verstehen und zu generieren. LLMs werden in einer Vielzahl von Anwendungen eingesetzt, darunter Konversations-KIs wie ChatGPT, Programmiertools wie GitHub Copilot und die OpenAI API, die Entwicklern ermöglicht, fortschrittliche Sprachverarbeitungsfunktionen in ihre Anwendungen zu integrieren. Diese Dienste nutzen die Fähigkeit von LLMs, menschenähnliche Texte zu generieren, komplexe Fragen zu beantworten und sogar Code vorzuschlagen oder zu vervollständigen.

Micromata ist ein erfahrener Partner, der die Herausforderungen bei der Anwendung von LLMs in der realen Welt genau versteht. Mit unserer Expertise in der Implementierung und Optimierung von LLM-basierten Systemen helfen wir Unternehmen, diese Technologien effektiv zu nutzen. Wir sind in der Lage, komplexe Probleme zu lösen, bei denen es darauf ankommt, umfangreiche Kontexte zu verwalten und externe Datenquellen nahtlos zu integrieren.

Dank unseres tiefgehenden Know-hows in den Bereichen Einbettungen, Vektorspeichern und RAG-Techniken können wir Lösungen entwickeln, die nicht nur technisch fortschrittlich, sondern auch auf die spezifischen Bedürfnisse unserer Kunden zugeschnitten sind.

Was sind Tokens?

Um die Funktionsweise und Leistungsfähigkeit von LLMs vollständig zu verstehen, ist es unerlässlich, sich mit den Konzepten von Tokens und Kontextfenstergröße vertraut zu machen. Tokens sind nämlich die Bausteine, mit denen LLMs Text verarbeiten: Sie teilen Sätze in kleinere Einheiten auf, die vom Modell analysiert werden. Die Kontextfenstergröße oder der Kontextbereich bestimmt, wie viel Text das Modell gleichzeitig verarbeiten kann. Beide Faktoren beeinflussen direkt, wie gut das Modell in der Lage ist, Zusammenhänge zu erkennen und kohärente, kontextbezogene Antworten zu generieren. Durch die Optimierung von Eingabeprompten unter Berücksichtigung dieser Konzepte können die Ergebnisse verbessert und die Nutzung von LLM-basierten Diensten effizienter gestaltet werden.

Durch das Verständnis, wie Tokens in LLMs verwendet werden, können Nutzer ihre Texte so gestalten, dass die Modelle effizienter und genauer arbeiten.

Kleinste Teilchen

In der natürlichen Sprachverarbeitung (Natural Language Processing, NLP) bezieht sich der Begriff „Token“ auf die kleinsten Einheiten, in die ein Text unterteilt wird, damit ein Sprachmodell ihn verarbeiten kann. Ein Token kann ein Wort, ein Teil eines Wortes (Subwort) oder sogar ein einzelnes Zeichen sein, abhängig davon, wie das Modell den Text segmentiert. Diese Segmentierung ist entscheidend, da das Modell nicht den gesamten Text auf einmal versteht, sondern ihn in diese kleineren, handhabbaren Einheiten aufteilt, um Muster zu erkennen und Bedeutungen abzuleiten.

LLMs wie die von OpenAI entwickelten Modelle zerlegen den eingegebenen Text in Tokens, bevor sie mit der Verarbeitung beginnen. Diese Tokens dienen als Grundlage für die Analyse des Textes durch das Modell. Ein Modell wie GPT kann Milliarden von Parametern verwenden, um den Zusammenhang zwischen diesen Tokens zu erkennen und darauf basierend Vorhersagen über den nächsten Token zu treffen. Die Art und Weise, wie ein Text in Tokens zerlegt wird, kann das Verständnis und die Reaktion des Modells erheblich beeinflussen.

Ein einfaches Beispiel für die Tokenisierung wäre der Satz „Das Wetter ist heute schön.“ Ein Modell könnte diesen Satz in die folgenden Tokens zerlegen: [„Das“, „Wetter“, „ist“, „heute“, „schön“, „.“]. In einigen Fällen kann die Tokenisierung komplexer sein, insbesondere bei Wörtern, die aus mehreren Morphemen bestehen oder bei zusammengesetzten Wörtern.

Die Tokenisierung kann aber auch dazu führen, dass Wörter in kleinere Einheiten aufgeteilt werden, um sie besser verarbeiten zu können. Beispielsweise kann das Wort „Maschinenlernen“ in „Maschinen“, „lern“ und „en“ zerlegt werden, was dem Modell hilft, die Bedeutung und den Kontext dieses zusammengesetzten Wortes besser zu erfassen.

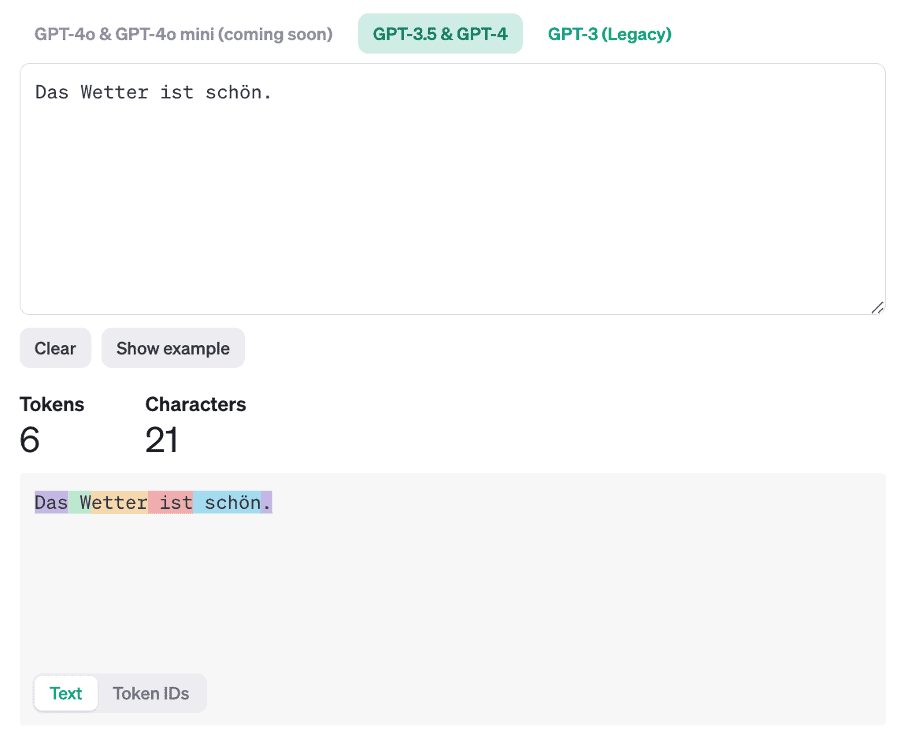

Der OpenAI Tokenizer

Ein nützliches Werkzeug, um zu sehen, wie Text in Tokens zerlegt wird, ist der OpenAI Tokenizer. Mit dem OpenAI Tokenizer können Benutzer ihren Text eingeben und sofort sehen, wie viele Tokens daraus resultieren. Dies ist besonders hilfreich, um die Länge und Komplexität von Eingaben zu überprüfen, insbesondere wenn man bedenkt, dass die Anzahl der Tokens die Kosten und die Reaktionszeit beeinflussen kann, wenn man mit APIs wie der OpenAI API arbeitet.

Was ist die Kontextfenstergröße?

Das Verständnis der Kontextfenstergröße und ihrer Auswirkungen auf die Modellleistung ist entscheidend für die effektive Nutzung von LLMs. Es ermöglicht Benutzern, ihre Eingaben so zu gestalten, dass sie die besten Ergebnisse erzielen, ohne wichtige Kontextinformationen zu verlieren.

Die Kontextfenstergröße, auch bekannt als Kontextlänge, bezeichnet die maximale Anzahl von Tokens, die ein Sprachmodell gleichzeitig verarbeiten kann. Innerhalb dieser Kontextfenstergröße wird der Text analysiert, um Zusammenhänge und Bedeutungen zu verstehen. Alles, was außerhalb dieses Fensters liegt, wird vom Modell nicht berücksichtigt, was die Qualität der Ausgabe beeinflussen kann. Die Kontextfenstergröße ist somit ein entscheidender Faktor für die Leistung von LLMs, da sie bestimmt, wie viel Kontext das Modell in einer einzigen Verarbeitungsrunde erfassen kann.

Die Kontextfenstergröße spielt eine zentrale Rolle dabei, wie gut ein Modell längere Texte versteht und zusammenhängende Antworten generieren kann. Je größer das Fenster, desto mehr Kontext kann das Modell auf einmal berücksichtigen, was besonders bei komplexen Aufgaben wie längeren Konversationen, Textgenerierungen oder der Verarbeitung von Dokumenten wichtig ist. Ein größeres Kontextfenster ermöglicht es dem Modell, weiter zurückliegende Informationen in der Eingabe zu berücksichtigen, was zu einer kohärenteren und relevanteren Ausgabe führt.

Zum Beispiel könnte ein Modell mit einer größeren Kontextfenstergröße in der Lage sein, den gesamten Kontext eines mehrteiligen Gesprächs besser zu erfassen und somit präzisere Antworten zu geben. In einem Dokument könnte das Modell auf frühere Absätze Bezug nehmen, um konsistente Aussagen zu treffen.

Trotz der Vorteile einer größeren Kontextfenstergröße gibt es auch signifikante Einschränkungen, wenn die Eingabe die maximale Kontextfenstergröße überschreitet. In solchen Fällen kann das Modell den überschüssigen Text nicht berücksichtigen, was dazu führt, dass relevante Informationen verloren gehen. Dies kann die Qualität der generierten Texte oder Antworten erheblich beeinträchtigen.

Ein praktisches Beispiel hierfür ist, wenn ein sehr langer Text analysiert werden soll, aber das Modell aufgrund der begrenzten Kontextfenstergröße nur die letzten paar Absätze berücksichtigt. Informationen aus den vorherigen Abschnitten, die für das Verständnis des gesamten Textes wichtig wären, werden dann ignoriert. Dies ist besonders problematisch in Anwendungen, die eine hohe Kohärenz und Präzision über längere Textabschnitte hinweg erfordern.

Um diese Einschränkungen zu umgehen, müssen Benutzer möglicherweise Techniken wie die Zusammenfassung des Textes, das Aufteilen in kleinere Abschnitte oder das selektive Auswählen der wichtigsten Teile des Textes anwenden, um innerhalb der Grenzen der Kontextfenstergröße zu bleiben. Solche Ansätze helfen, die relevantesten Informationen im Fokus zu behalten, auch wenn das Modell nicht den gesamten Text auf einmal verarbeiten kann.

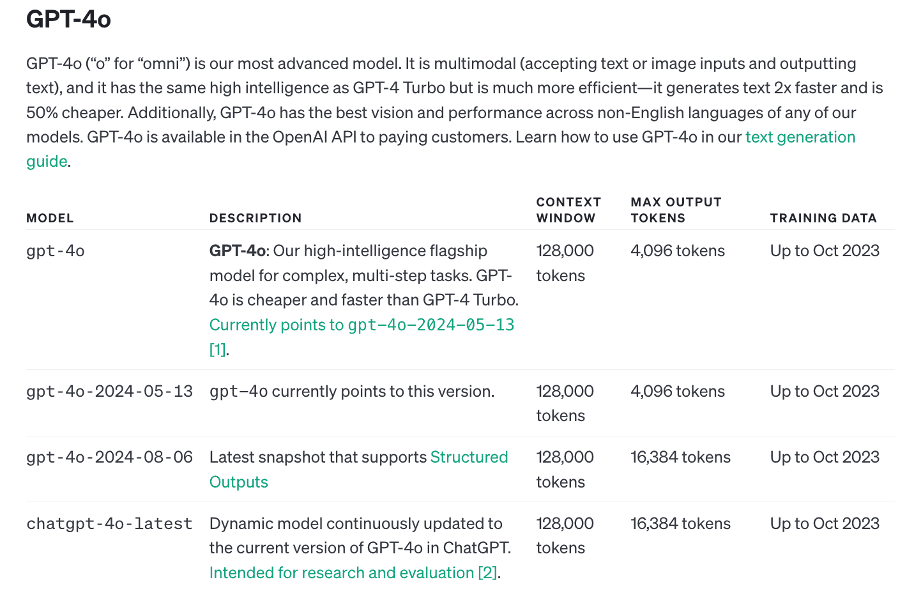

Das Modell GPT-4o ist das Flaggschiff unter den Modellen von OpenAI, das speziell für komplexe und mehrstufige Aufgaben entwickelt wurde. Im Vergleich zu anderen Modellen bietet GPT-4o eine kostengünstigere und schnellere Verarbeitung, was es zu einer attraktiven Wahl für Anwendungen macht, die sowohl hohe Leistungsfähigkeit als auch Effizienz erfordern.

Die Eingabe-Kontextfenstergröße von GPT-4o beträgt 128.000 Tokens. Dies bedeutet, dass das Modell in der Lage ist, einen sehr großen Kontext auf einmal zu verarbeiten, was besonders vorteilhaft für Aufgaben ist, die umfangreiche Datenmengen oder komplexe Konversationen mit vielen verschiedenen Informationen erfordern. Mit einem so großen Eingabefenster kann das Modell lange Texte, umfangreiche Dokumente oder detaillierte Anfragen in ihrer Gesamtheit berücksichtigen, ohne dass wesentliche Informationen abgeschnitten werden müssen.

Ein großes Eingabe-Kontextfenster ist besonders nützlich in Szenarien, in denen der gesamte Kontext für das Verständnis oder die Generierung einer präzisen Antwort entscheidend ist. Zum Beispiel bei der Analyse langer wissenschaftlicher Artikel oder beim Verarbeiten von detaillierten Berichten und umfangreichen Datenbanken kann GPT-4o den kompletten Kontext über viele Tausende von Tokens hinweg erfassen und nutzen.

Die Ausgabe-Kontextfenstergröße von GPT-4o beträgt 4.096 Tokens. Dies bezieht sich auf die maximale Länge der Antwort oder des generierten Textes, den das Modell in einem Durchgang erzeugen kann. Obwohl dieses Ausgabefenster kleiner ist als das Eingabefenster, bietet es dennoch genügend Platz, um detaillierte und komplexe Antworten zu generieren.

Die Begrenzung des Ausgabefensters auf 4.096 Tokens erfordert in manchen Fällen eine sorgfältige Planung, insbesondere wenn das Modell aufgefordert wird, lange Antworten zu generieren oder wenn es darum geht, dass die Antwort mehrere Absätze oder detaillierte Anweisungen umfasst. Dennoch reicht diese Größe für die meisten Anwendungen aus, einschließlich der Erstellung von Berichten, der Beantwortung von Fragen oder der Generierung von komplexen Texten, die mehrere Absätze umfassen.

Die Unterscheidung zwischen Eingabe- und Ausgabe-Kontextfenstergröße ist entscheidend für das Verständnis, wie das Modell Informationen verarbeitet und Antworten generiert. Das große Eingabefenster ermöglicht es GPT-4o, umfangreiche und detaillierte Kontexte zu analysieren, was zu einer besseren und kontextuell präziseren Verarbeitung führt. Das etwas kleinere Ausgabefenster stellt sicher, dass die generierten Antworten fokussiert und relevant bleiben, ohne übermäßige Redundanzen.

Einbettungen und Vektorspeicher

Durch das Verständnis und die Nutzung von Einbettungen und Vektorspeichern können Entwickler und Datenwissenschaftler leistungsstarke Anwendungen schaffen, die tiefere semantische Beziehungen verstehen und nutzen. Dies führt zu intelligenteren, kontextbewussteren Systemen, die in der Lage sind, relevantere und genauere Ergebnisse zu liefern.

Einbettungen (Embeddings) sind eine Technik in der natürlichen Sprachverarbeitung, bei der Wörter, Sätze oder sogar ganze Dokumente in Vektoren umgewandelt werden – mathematische Darstellungen in einem kontinuierlichen Raum mit hoher Dimensionalität. Diese Vektoren repräsentieren die semantischen Beziehungen zwischen den Wörtern: Wörter, die in ähnlichen Kontexten verwendet werden, haben ähnliche Vektoren. Einbettungen ermöglichen es Sprachmodellen, die Bedeutung von Text auf einer tieferen Ebene zu erfassen, indem sie komplexe sprachliche Muster und Zusammenhänge erkennen.

In LLMs werden Tokens in Einbettungen umgewandelt, bevor sie weiter verarbeitet werden. Dieser Prozess ist entscheidend, da er die Grundlage dafür bildet, wie das Modell semantische Ähnlichkeiten und Beziehungen erkennt. Durch Einbettungen kann das Modell beispielsweise verstehen, dass die Wörter „Hund“ und „Katze“ zwar unterschiedlich sind, aber in vielen Kontexten ähnliche Bedeutungen oder Rollen spielen, da ihre Einbettungen im Vektorraum nahe beieinander liegen.

Einbettungen ermöglichen es dem Modell, weit über die reine syntaktische Analyse hinauszugehen und kontextuelle Bedeutungen zu erfassen. Dies ist besonders wichtig in Anwendungen, bei denen es darauf ankommt, nicht nur den Wortlaut, sondern auch die zugrunde liegende Bedeutung des Textes zu verstehen.

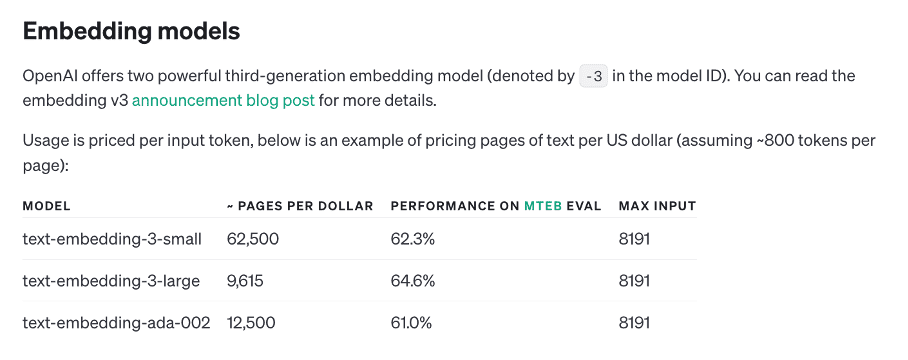

Die OpenAI Embedding API bietet eine leistungsstarke Möglichkeit, Text in numerische Vektoren umzuwandeln, die die semantische Bedeutung des Textes erfassen. Diese Vektoren, auch als Einbettungen bekannt, sind entscheidend für Aufgaben wie die semantische Suche, Clustering, und die Empfehlung von Inhalten. Die API ermöglicht es, Texte unterschiedlicher Länge in dichte Vektoren umzuwandeln, die in Vektorspeichern gespeichert und später für effiziente Ähnlichkeitssuchen oder andere maschinelle Lernaufgaben genutzt werden können. Mehr Informationen und eine detaillierte Anleitung zur Nutzung der Embedding API finden Sie auf der offiziellen OpenAI-Dokumentationsseite.

Ein Vektorspeicher (Vector Store) ist ein spezialisierter Datenspeicher, der für die effiziente Speicherung und Abfrage von Einbettungen entwickelt wurde. Vektorspeicher ermöglichen es, große Mengen an Vektoren zu speichern und schnell Ähnlichkeitssuchen durchzuführen, indem sie Vektoren vergleichen und die nächsten Nachbarn im Vektorraum finden.

Einige gängige Beispiele für Vektorspeicher sind Pinecone, Chroma, FAISS und Weaviate. Diese Systeme werden häufig in Anwendungen eingesetzt, die große Mengen an semantisch ähnlichen Daten durchsuchen oder kontextbezogene Informationen schnell abrufen müssen, wie etwa in Empfehlungssystemen oder bei der semantischen Suche.

Einbettungen und Vektorspeicher haben in der Praxis zahlreiche Anwendungen. Ein Beispiel ist die semantische Suche, bei der Benutzeranfragen nicht nur auf Basis der exakten Wortübereinstimmung, sondern auf Basis der Bedeutung durchsucht werden. Vektorspeicher ermöglichen es, relevante Informationen basierend auf semantischen Ähnlichkeiten schnell zu finden.

Ein weiteres Beispiel ist der Einsatz in Empfehlungssystemen, bei denen Vektorspeicher dazu verwendet werden, Produkte, Filme oder andere Inhalte vorzuschlagen, die ähnlich zu denen sind, die der Benutzer zuvor gemocht hat. Hierbei werden die Einbettungen von Benutzerpräferenzen und verfügbaren Inhalten verglichen, um personalisierte Empfehlungen zu erzeugen.

In der kontextbezogenen Datenwiederverwendung können Vektorspeicher genutzt werden, um relevante Absätze oder Dokumente zu finden, die einer bestimmten Anfrage am nächsten kommen, selbst wenn diese Anfrage in anderer Form oder mit unterschiedlichen Worten gestellt wird.

Retrieval-Augmented Generation (RAG)

Die Nutzung von RAG bietet erhebliche Vorteile, insbesondere in Bereichen, in denen präzise und kontextuell relevante Informationen entscheidend sind. Durch die Kombination von Abruf und Generierung können Entwickler Systeme schaffen, die nicht nur intelligenter, sondern auch wesentlich nützlicher und benutzerfreundlicher sind.

Retrieval-Augmented Generation (RAG) ist eine fortschrittliche Technik, die die Fähigkeiten von großen Sprachmodellen (LLMs) erweitert, indem sie eine Kombination aus Informationsabruf und Textgenerierung verwendet. In einem RAG-System wird zunächst relevante externe Information abgerufen (Retrieval), die dann in die Generierung der Antwort einfließt. Diese Methode ermöglicht es, präzisere und informativere Antworten zu generieren, da das Modell auf eine größere Wissensbasis zugreifen kann, anstatt sich nur auf das zu stützen, was innerhalb des begrenzten Kontextfensters vorhanden ist.

Im Wesentlichen kombiniert RAG die Stärke von Informationsabrufsystemen, die schnell relevante Daten aus großen Datenbanken oder Vektorspeichern heraussuchen können, mit der Fähigkeit von LLMs, kohärenten und kontextbezogenen Text zu generieren. Dies macht RAG besonders nützlich in Anwendungen wie Frage-Antwort-Systemen, Chatbots oder in der personalisierten Content-Generierung.

Der Hauptvorteil von RAG liegt in seiner Fähigkeit, die Leistung und Genauigkeit von LLMs erheblich zu verbessern. Durch die Einbeziehung von abgerufenen Informationen können die Modelle nicht nur auf den im Modell eingebetteten Trainingsdaten basieren, sondern auch auf aktuelle, spezifische und kontextrelevante Daten zugreifen. Dies ist besonders wichtig in Bereichen, in denen präzise und aktuelle Informationen erforderlich sind, wie z. B. in der Medizin, im Rechtswesen oder bei technischen Anfragen.

Ein weiterer Vorteil von RAG ist die Flexibilität bei der Verarbeitung von komplexen Anfragen. Indem relevante Informationen abgerufen und dem Modell zur Verfügung gestellt werden, können komplexe oder mehrstufige Anfragen besser verstanden und beantwortet werden. Dies führt zu einer höheren Zufriedenheit der Benutzer, da die Antworten genauer und relevanter sind.

Beispielsweise könnte ein RAG-System in einem medizinischen Chatbot verwendet werden, um relevante medizinische Artikel oder Datenbanken zu durchsuchen und diese Informationen dann zu nutzen, um fundierte und aktuelle Antworten auf Patientenanfragen zu geben. In einem anderen Anwendungsfall könnte RAG verwendet werden, um in einem technischen Supportsystem spezifische Anleitungen oder Dokumentationen abzurufen und daraus präzise Problemlösungen zu generieren.

Die Implementierung von RAG erfordert eine Integration zwischen einem LLM und einem effizienten Abrufsystem, wie einem Vektorspeicher. Ein typischer RAG-Workflow könnte folgendermaßen aussehen:

-

- Eingabeanalyse: Die Anfrage wird in Tokens zerlegt und in eine Einbettung umgewandelt.

- Informationsabruf: Basierend auf der Einbettung wird eine Suche im Vektorspeicher durchgeführt, um relevante Dokumente oder Daten zu finden.

- Generierung: Die abgerufenen Informationen werden dann als zusätzlicher Kontext verwendet, um eine detaillierte und präzise Antwort zu generieren.

Die Implementierung von RAG kann je nach Anwendungsfall angepasst werden. Es können beispielsweise verschiedene Strategien für die Auswahl und Gewichtung der abgerufenen Informationen entwickelt werden, um sicherzustellen, dass nur die relevantesten Daten in die Generierung einfließen.

Ein Beispiel für die Implementierung von RAG ist die Verwendung in einem unternehmensinternen Wissensmanagementsystem, wo das Modell relevante interne Dokumente abrufen und in Antworten auf Mitarbeiteranfragen einbeziehen kann. Dies spart Zeit und verbessert die Genauigkeit der Antworten, indem die relevantesten und aktuellsten Informationen genutzt werden.

Relevanz in LLM-basierten Diensten

Durch das Verständnis und die geschickte Nutzung von Tokens, Kontextfenstergröße, Einbettungen, Vektorspeichern und RAG können Entwickler und Nutzer die Effizienz und Präzision von LLM-basierten Diensten wie ChatGPT, der OpenAI API und GitHub Copilot erheblich steigern. Diese Konzepte sind zentral für die Optimierung der Benutzererfahrung und für die Schaffung intelligenterer und kontextbewussterer Anwendungen.

ChatGPT

ChatGPT, ein prominentes Beispiel für einen LLM-basierten Dienst, ist stark auf die effiziente Nutzung von Tokens, Kontextfenstergröße und Einbettungen angewiesen, um qualitativ hochwertige und kontextuell kohärente Antworten zu generieren.

-

- Tokens und Kontextfenstergröße: Bei einer Konversation mit ChatGPT beeinflusst die Anzahl der Tokens direkt, wie viel Kontext das Modell gleichzeitig verarbeiten kann. Eine gut optimierte Eingabe, die die Kontextfenstergröße berücksichtigt, führt zu besseren Antworten, da das Modell mehr Kontext aus der laufenden Konversation nutzen kann. Wenn die Konversation jedoch zu lang wird und die Token-Limits überschreitet, muss das Modell möglicherweise früheren Kontext abschneiden, was zu weniger präzisen Antworten führen kann.

- Einbettungen: Einbettungen spielen eine zentrale Rolle bei der semantischen Verarbeitung der Konversation. Sie helfen ChatGPT, den tieferen Kontext von Benutzeranfragen zu verstehen und relevante Antworten zu generieren, die über bloße Wortähnlichkeiten hinausgehen. Dies führt zu natürlicheren und sinnvolleren Dialogen.

- RAG-Potenzial: Während ChatGPT hauptsächlich auf den in seinen Trainingsdaten eingebetteten Informationen basiert, könnte eine Integration von RAG (Retrieval-Augmented Generation) die Fähigkeit des Modells erweitern, auf aktuelle und spezifische Informationen zuzugreifen. Dies wäre besonders nützlich in Szenarien, in denen Benutzer aktuelle oder sehr spezifische Daten benötigen, die außerhalb des festen Wissens des Modells liegen.

OpenAI API

Die OpenAI API bietet Entwicklern Zugang zu den leistungsstarken Fähigkeiten von LLMs und stellt ihnen die Werkzeuge zur Verfügung, um fortschrittliche Sprachverarbeitung in ihre Anwendungen zu integrieren.

-

- Tokens und Kosten: Bei der Nutzung der OpenAI API spielt die Anzahl der Tokens eine entscheidende Rolle, nicht nur für die Qualität der Antworten, sondern auch für die Kosten der API-Nutzung. Die API berechnet die Kosten basierend auf der Anzahl der verwendeten Tokens, was bedeutet, dass eine effiziente Token-Nutzung entscheidend ist, um Kosten zu sparen und gleichzeitig die gewünschte Funktionalität zu gewährleisten.

- Kontextfenstergröße: Die Kontextfenstergröße bestimmt, wie viel Kontext eine Anfrage enthalten kann. Entwickler müssen sorgfältig überlegen, wie sie Anfragen formulieren, um sicherzustellen, dass wichtige Informationen innerhalb des Kontextfensters bleiben und somit die besten Ergebnisse erzielen.

- Einbettungen und Vektorspeicher: Für Entwickler, die semantische Suchfunktionen oder Ähnliches integrieren möchten, sind Einbettungen und Vektorspeicher unverzichtbare Werkzeuge. Sie ermöglichen die Erstellung von Anwendungen, die auf tiefere semantische Zusammenhänge zugreifen können, etwa durch die Implementierung von Empfehlungssystemen oder durch die Verbesserung von Suchergebnissen.

- RAG-Implementierung: Die OpenAI API lässt sich auch mit RAG-Methoden kombinieren, um den Informationsgehalt und die Aktualität der generierten Texte zu erhöhen. Entwickler können Vektorspeicher verwenden, um relevante Informationen aus großen Datenbanken abzurufen und diese in die Generierung einzubinden, was besonders in datenintensiven Anwendungen nützlich ist.

GitHub Copilot

GitHub Copilot, ein KI-gestütztes Werkzeug zur Codevervollständigung, nutzt die Konzepte von Tokens, Kontextfenstergröße, Einbettungen und möglicherweise auch RAG, um Entwicklern beim Schreiben von Code zu helfen.

-

- Tokens und Kontextfenstergröße: Bei der Codevervollständigung sind Tokens und Kontextfenstergröße entscheidend, da der Kontext des Codes, den ein Entwickler schreibt, oft sehr wichtig ist. GitHub Copilot muss in der Lage sein, den aktuellen Codeabschnitt sowie den umgebenden Kontext (vorheriger Code, Kommentare) zu berücksichtigen, um nützliche und präzise Vorschläge zu machen. Die Begrenzung der Kontextfenstergröße kann jedoch dazu führen, dass Copilot Teile des Codes ignoriert, was zu weniger präzisen Vorschlägen führen kann.

- Einbettungen: Einbettungen würden es Copilot ermöglichen , den semantischen Gehalt des Codes zu verstehen, indem sie Muster und Zusammenhänge in der Programmierlogik erkennen. Dadurch könnte das Werkzeug kontextbewusste und relevante Codevorschläge machen, die über einfache Syntaxvervollständigungen hinausgehen. Allerdings scheint Github Copilot sich bisher nur experimentell damit zu beschäftigen (https://github.blog/ai-and-ml/github-copilot/how-github-copilot-is-getting-better-at-understanding-your-code/).

- RAG in der Codevervollständigung: Eine zukünftige Integration von RAG in GitHub Copilot dazu führen, dass das Tool spezifische, kontextbezogene Codebeispiele aus großen Codebasen oder Dokumentationen abruft, um präzisere und besser angepasste Vorschläge zu machen. Dies würde die Effizienz und Qualität der Codevervollständigung weiter verbessern.

Schlussfolgerung

Die Nutzung von Large Language Models (LLMs) wie ChatGPT, OpenAI API und GitHub Copilot bietet immense Potenziale zur Lösung komplexer realer Probleme. Ein tiefes Verständnis der zugrunde liegenden Konzepte wie Tokens, Kontextfenstergröße, Einbettungen, Vektorspeichern und Retrieval-Augmented Generation (RAG) ist entscheidend, um das volle Potenzial dieser Technologien auszuschöpfen.

In der Praxis stehen viele Anwendungen vor der Herausforderung, dass die Kontextfenstergröße der Modelle begrenzt ist. Wenn der benötigte Kontext den Rahmen dessen, was das Modell in einem Durchlauf verarbeiten kann, überschreitet, kann dies zu Informationsverlusten und weniger präzisen Ergebnissen führen. Hier kommt das tiefe Verständnis der Komplexität von LLMs ins Spiel: Durch die Anwendung von Techniken wie RAG können externe Datenbanken oder Dienste einbezogen werden, um den Kontext dynamisch zu erweitern und so relevantere und genauere Antworten zu generieren.

Micromata steht Ihnen als kompetenter Partner zur Seite, um die Herausforderungen moderner KI-Anwendungen erfolgreich zu meistern und den maximalen Nutzen aus den Technologien der nächsten Generation zu ziehen.